嘿,各位同学,我是雪狼。

当我们谈论 AI 应用时,你的脑海中是不是立刻浮现出那些炫酷的词汇:海量数据、神经网络、深度学习、大语言模型(LLM)?没错,「机器学习」这台引擎,的确在模式识别、未来预测和创意生成方面展现了令人咋舌的「魔法」!

然而,AI 的世界并非只有「机器学习」这一种「驱动力」。在它闪耀之前,还有一位同样古老而强大的「智者」 —— 专家系统(Expert Systems),它如同饱含人生智慧的老者,基于清晰的知识与规则进行逻辑推理。

那么问题来了,面对复杂的业务场景,我们究竟是选择听从数据「直觉」的机器学习,还是遵循严谨「逻辑」的专家系统?雪狼告诉你,小孩子才做选择,成年人全都要!

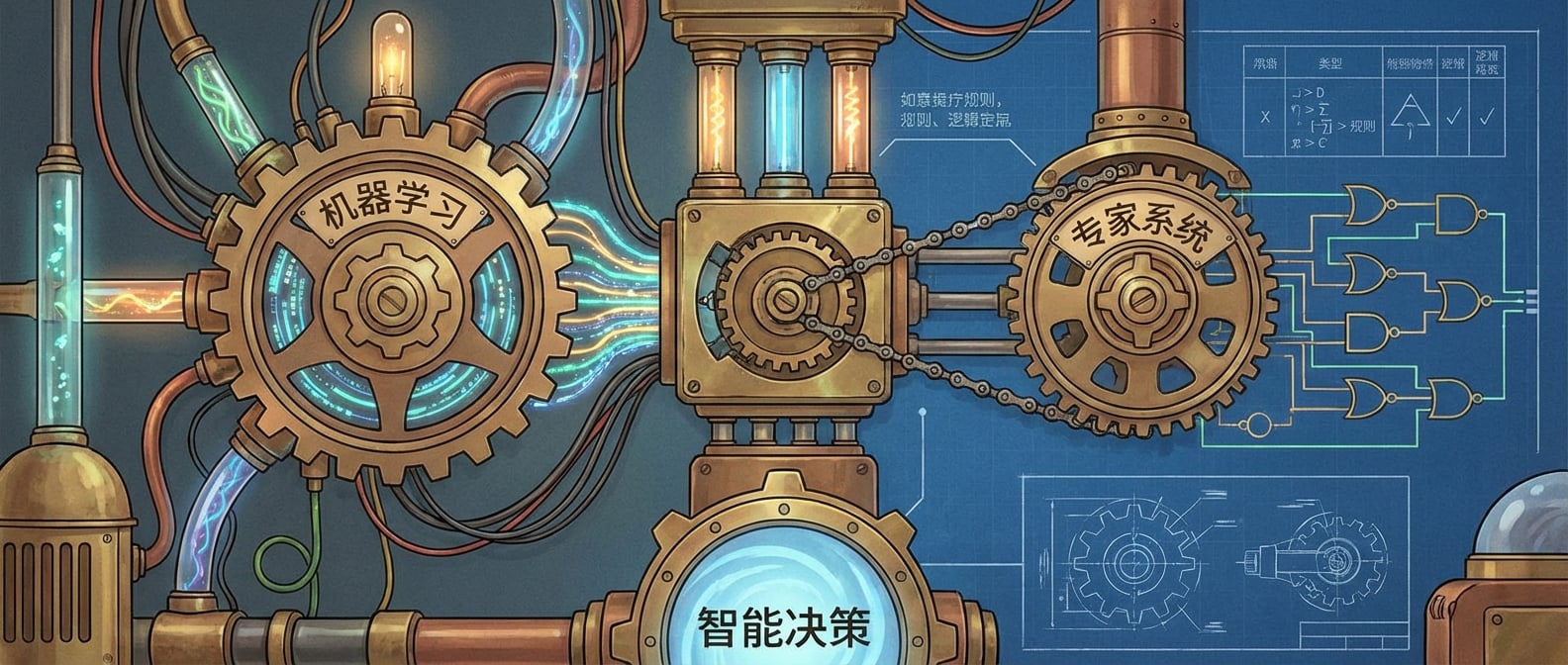

这篇文章,雪狼将为你揭示一种更高级、更稳健的 AI 应用架构哲学: 「双引擎」设计。它主张将机器学习那种「从混沌中发现秩序」的模式发现能力,与专家系统那「循规蹈矩、滴水不漏」的知识推理能力巧妙结合。只有这样,我们才能构建出更智能、更可靠,甚至更能「自圆其说」的 AI 应用,打破那些让人不安的「黑箱」魔咒!

引擎一:机器学习 (Machine Learning) —— 数据汪洋中的「寻宝猎人」#

想象一下,这台引擎就像一位天赋异禀的「寻宝猎人」 。它不会被告知宝藏具体在哪,但你给它足够多的藏宝图(数据),它就能凭借敏锐的直觉和强大的分析能力,从浩如烟海的线索中,自己摸索出宝藏的规律和位置。

-

它的哲学:「道法自然,从数据中来,到数据中去」 。我们无需像传统编程那样,对每一个问题都事无巨细地编写规则。它通过分析海量数据,自己就能「顿悟」出隐藏在深处的模式与关联,并以此进行预测或分类。

-

它的工作原理:它拥有一套强大的「学习算法」(比如那些深奥的神经网络、精密的决策树、巧妙的回归模型),这些算法在海量「实战数据」中反复锤炼,最终习得了「举一反三」的本领,能够将各种输入信息,准确地映射到它应得的输出结果。

-

它的超级能力 (优势):

-

模式洞察:擅长在那些复杂到人类大脑都难以处理、非结构化到一塌糊涂的数据中,发现常人难以察觉的深层模式和规律。

-

自我迭代:随着新数据的不断涌入,它能像一位不断进化的武者,通过再训练,持续优化自身,适应新的「战场」环境。

-

通吃非结构化数据:尤其是在图像识别、语音理解、自然语言处理这些领域,深度学习模型简直就是「降维打击」般的存在。

-

-

它的阿喀琉斯之踵 (劣势):

-

「黑箱」之谜:这往往是它的「原罪」。模型为何做出某个判断?决策过程常常像个谜团,让人难以捉摸。它只告诉你结果,不解释缘由,这在需要高可信度的场景下,确实让人头疼。

-

数据饥渴症:它是个不折不扣的「数据饕餮」。没有大规模、高质量、且标注精良的数据,它就如同巧妇难为无米之炊,根本无法展现其神威。

-

「刻舟求剑」的风险:一旦遇到与训练数据分布差异巨大、前所未见的新情况,它的表现可能就会「水土不服」,甚至「掉链子」。它的泛化能力并非无限。

-

引擎二:专家系统 (Expert Systems) —— 智慧王国里的「首席大法官」#

如果说机器学习是数据世界的「寻宝猎人」,那么专家系统,则更像是一位坐镇智慧王国的「首席大法官」 。它不依赖直觉和模式,而是严格依据人类预设的法律条文(知识)和逻辑推演(规则)来做出判断。

-

它的哲学:「大道至简,法度森严,将人类智慧明码标价」 。它将领域专家的宝贵经验、行业规范、决策流程,以结构化、符号化的形式,清晰地编码进系统。一切行为皆有法可依,有据可查。

-

它的工作原理:它由两大部分构成:一套是记载着所有「法律条文」和「判例」(事实、规则、启发式)的知识库;另一套是能够依据这些「法律条文」进行严谨推演,最终给出「判决」的推理引擎。

-

它的超级能力 (优势):

-

明察秋毫:最显著的特点就是它的可解释性。它能清楚地告诉你,为什么做出这个决定,每一步推导的依据是什么,例如:「因为你满足了规则 X 的条件 Y,所以得出结论 Z」。这在金融、医疗等容错率极低的领域,简直就是「定海神针」。

-

公正透明:决策过程完全透明,易于审计、调试和理解。任何一个决策,你都能追溯其源头。

-

无惧数据稀缺:在数据量少,但专家经验丰富的场景下,它能发挥奇效。即便数据贫瘠,只要专家智慧足够,它依然能推理出高价值的结论。

-

言出必行:在既定规则覆盖的范围内,它的行为是完全确定、可预测的。没有意外,只有严丝合缝的逻辑。

-

-

它的阿喀琉斯之踵 (劣势):

-

知识获取之困:最大的痛点在于知识获取瓶颈。把人类专家脑海中那些只可意会不可言传的经验,准确、完整、无歧义地编码成机器能懂的规则,这是一项浩大且耗时的工程。

-

扩展性受限:随着规则的增多,知识库会变得越来越庞大和复杂。管理、维护和协调这些规则,可能会演变成一场噩梦,就像管理一部不断膨胀的法律全书。

-

固步自封:它无法像机器学习那样,从新数据中「开悟」出新的知识。所有的规则必须由人类手动更新,一旦外部世界发生变化,它就可能「脱节」。

-

无法处理模糊:对于模糊不清、模棱两可的情况,专家系统会显得束手无策,因为它只认白纸黑字的规则。

-

「双引擎」设计:AI 智能体驾驭之道#

所以,各位同学,当你还在纠结是选「数据寻宝猎人」还是「智慧大法官」时,雪狼告诉你:真正能够驾驭 AI 智能体、构建强大应用之道,在于巧妙地运用「双引擎」协同工作。

-

核心理念:这正是我们常说的「取长补短,互为犄角」。用机器学习的强大「直觉」和「模式发现」能力去探索未知、处理模糊;用专家系统严谨的「逻辑推理」和「规则控制」去锚定已知、提供解释。

-

雪狼的比喻:我们可以把机器学习想象成一台全地形高速越野车,它能在大数据的荒野中风驰电掣,发现新的路径和宝藏。而专家系统,则是一个精密的路标系统与交通规则,它确保越野车在关键节点不偏离方向,并能解释为何选择某条路线。两者结合,才能让 AI 应用既有探索的广度,又有决策的深度与可控性。

融合的艺术:炼就智能「合璧」#

「双引擎」的融合并非简单的堆叠,而是一门艺术,需要我们根据具体业务场景,精心设计它们之间的协作模式。

-

机器学习的「直觉」作为专家系统的「线索」:这是最常见也最有效的融合方式。机器学习模型可以先进行初步的模式识别和预测(例如,「这笔交易有 80% 的概率是欺诈!」)。然后,这个「直觉性」的预测结果,会作为专家系统中的一个「事实」或「线索」输入。专家系统则会基于此,结合预设的业务规则,做出最终的、可解释的决策(例如:「如果机器学习模型预测欺诈概率大于 70%,并且用户来自高风险地区,则立即拦截交易并通知人工审核,理由是……」)。这样,系统既能发现未知的欺诈模式,又能对高风险行为给出明确的、可审计的解释。

-

专家系统预设「护栏」,机器学习在「赛道」上驰骋:专家系统可以作为数据进入机器学习流程前的「守门员」或「预处理器」。例如,它先对数据进行初步过滤、分类或标准化(例如:「只有那些满足了 XXXXX 条件的客户投诉,才需要发送给大语言模型进行情感分析和摘要」)。这不仅能减少机器学习模型的处理负担,使其能更专注于核心任务,还能提前排除一些不符合业务逻辑或安全规范的「脏数据」。

-

并行决策与「仲裁委员会」:在某些场景下,两种引擎可以并行独立地给出建议。然后,一个更高级的「仲裁机制」 (可以是一个更复杂的规则集,也可以是人类专家)来权衡利弊,做出最终的判断。这如同法庭上的陪审团,综合各方意见。

实践案例:金融欺诈检测 —— AI 时代的「火眼金睛」#

在金融风控领域,欺诈检测就像一场永无止境的猫鼠游戏。传统的规则系统面对不断变异的欺诈手段,往往力不从心。而单一的机器学习模型,虽然能识别新模式,却又难以提供清晰的解释,让风控人员背负巨大压力。此时,「双引擎」设计的价值便凸显无疑:

-

机器学习引擎:它像一位资深的数据侦探,夜以继日地在海量的历史交易数据中穿梭,通过学习,嗅探出那些肉眼难辨、模式隐蔽的欺诈「蛛丝马迹」。它可能发现,某些看似不相关的交易行为组合,一旦同时出现,就是欺诈的高风险信号。

-

专家系统引擎:它则是风控体系中「铁面无私」的法律顾问。内置着明确的业务规则,例如:「如果单笔交易金额超过 10000 美元 并且 发生在境外 并且 用户从未有过境外交易记录,那么立即标记为高风险交易,并直接触发冻结流程,并通知人工审核。」这些都是硬性、白纸黑字的规则,确保了风控决策的确定性和可追溯性。

-

双引擎协同:将机器学习模型输出的「欺诈风险评分」作为专家系统规则的重要输入。例如,可以设定一条规则:「如果机器学习模型预测某笔交易的欺诈概率超过 0.6,那么,即使它没有直接触犯任何硬性规则,也必须触发专家系统进行更深层次的审查,并要求用户进行二次验证。」

这样一来,系统既能凭借机器学习的「直觉」发现未知威胁,又能通过专家系统的「理性」对高风险行为提供明确、可信的解释和处理方案。这种「感性与理性」的完美结合,让 AI 的「火眼金睛」更加明亮,也让我们的风控体系更加坚不可摧。

结语:大道不孤,德必有邻#

各位同学,构建强大的 AI 应用,切忌「一根筋」,只钟情于单一的技术流派。真正的「架构之道」,在于胸怀天下,兼容并包,以开放的心态,采众家之长,实现「大道不孤,德必有邻」 (出自《论语》)。

「双引擎」设计,正是这种思想的绝佳体现。它通过巧妙地融合机器学习的「模式发现」能力和专家系统的「知识推理」能力,不仅能构建出更智能、更可靠、更具可解释性的 AI 应用,更是打破 AI 「黑箱」魔咒,通往一个更强大、更负责任的智能未来的必由之路。

我是雪狼,期待下次与你在技术的山巅相遇!