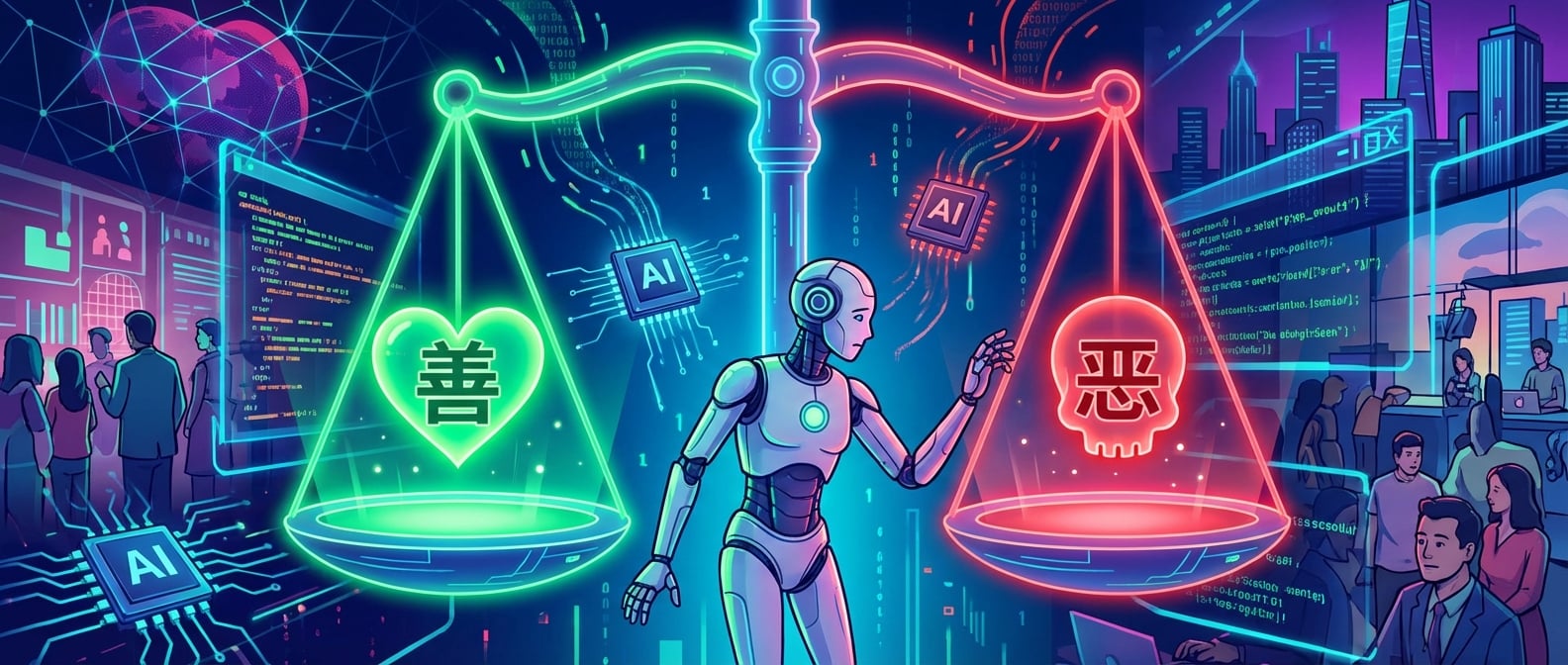

当代码有了「善恶」之分,你觉得 AI 的决策是冰冷的逻辑,还是有温度的权衡?自动驾驶的「电车难题」,医疗 AI 的生死抉择,金融算法的公平拷问……这些并非科幻,而是智能时代 AI 必须直面的「道德困境」。作为开发者,我们该如何编程,才能让机器在关键时刻做出「正确」的道德选择?作为人类,我们又该如何为 AI 注入「道德血液」,确保科技进步与人文伦理的和谐共存?雪狼今天就和大家深入探讨 AI 决策中的道德困境,揭示这些困境对人类社会带来的深远影响,共同寻找答案。

一、AI 的「自主决策」与道德困境的诞生#

传统的机器只是执行人类指令的工具,其行为的道德责任完全归属于人类。但当 AI 具备了自主学习、自主决策的能力时,它就可能面临必须在两个或多个相互冲突的道德选项中做出选择的场景,从而产生了「道德困境」。

1. 自动驾驶的「电车难题」#

-

场景:一辆自动驾驶汽车面临紧急情况,前方是突然冲出的儿童,侧方是行人,为了避免撞向儿童,AI 可能需要选择撞向行人,反之亦然。AI 应该优先保护谁的生命?

-

困境:无论选择哪个选项,都将导致无法避免的伤害,AI 系统需要在不同的生命价值之间进行权衡。

-

比喻:生命的「权重」:

自动驾驶的「电车难题」并非科幻,而是现实中的道德拷问。它迫使我们思考,在代码的世界里,生命的「权重」应该如何定义?是「多数人的福祉」,还是「弱势优先」?

2. 医疗 AI 的「生死抉择」#

-

场景:AI 辅助医疗诊断系统,在资源有限的情况下,需要决定将有限的医疗资源(如呼吸机、药物)分配给哪位病人。

-

困境:是选择治愈可能性最大的病人?还是年轻的病人?或是贡献最大的病人?

-

伦理冲突:公平、效率、生命权等价值观在此刻相互冲突。

3. 金融 AI 的「风险与公平」#

-

场景:AI 信贷评估系统,在评估申请人信用时,可能面临效率与公平的权衡。

-

困境:如果 AI 模型为了提高效率,通过算法偏见将某些群体(如少数族裔、低收入人群)排除在信贷服务之外,这是否道德?

-

社会影响:算法偏见可能固化社会不平等。

二、AI 道德困境的根源:价值观的缺失与冲突#

AI 面临道德困境的根本原因在于:

-

缺乏人类的「价值观」:AI 是基于数据和算法的,它无法像人类一样拥有情感、同理心、良知和价值观。

-

人类价值观的「不一致」:即使是人类,在面对道德困境时也常常难以达成共识,更遑论将这些模糊的、冲突的价值观清晰地编码到 AI 系统中。

-

代码的「善恶中立」:代码本身是中立的,但当它被赋予决策权时,就必须承载「善恶」的判断。

三、如何为 AI 注入「道德血液」:构建伦理 AI 的路径#

解决 AI 的道德困境,并非一蹴而就,需要多学科、多方位的努力。

1. 伦理嵌入式设计 (Ethics by Design)#

-

前瞻性思考:在 AI 系统设计之初,就应充分考虑潜在的道德困境和伦理风险。

-

明确价值观:将人类社会的核心伦理原则(如公平、透明、负责任)明确地嵌入 AI 系统设计中。

-

多方参与:伦理学家、法学家、社会学家、用户等应全程参与 AI 系统的设计和开发。

2. 数据与算法的伦理优化#

-

去偏见数据:主动识别并消除训练数据中的偏见,确保数据的多样性和代表性。

-

可解释性 AI (XAI):提高 AI 模型的透明度和可解释性,让其决策过程可被审计和理解。

-

公平性算法:设计或选择能够兼顾公平性指标(而不仅仅是准确率)的算法。

-

比喻:为代码搭建「道德罗盘」:

这不是给代码加上「善恶开关」,而是为它搭建一个「道德罗盘」,让它在复杂的环境中,能够根据预设的伦理原则,找到相对「正确」的方向。

3. 人类在环 (Human-in-the-Loop)#

-

AI 辅助决策:在关键决策点,AI 应作为辅助工具,最终决策权仍由人类掌握。

-

实时干预与修正:设计 AI 系统时,必须保留人类实时干预、修正 AI 决策的机制。

-

紧急停止按钮:对于高风险 AI 系统,必须具备「一键关停」的能力。

4. 法律法规与社会共识#

-

完善立法:出台明确的法律法规,规范 AI 的伦理边界和责任归属。

-

加强伦理教育:提升 AI 开发者、使用者和社会公众的 AI 伦理素养。

-

国际合作:建立全球性的 AI 伦理治理框架,应对跨国界的道德困境。

结语#

AI 的「道德困境」,是人类在智能时代必须直面且解决的「终极问题」。它提醒我们,科技进步不能脱离人文伦理的轨道。当代码有了「善恶」之分,正是人类社会需要展现更高智慧和责任担当的时刻。

为 AI 注入「道德血液」,不是要让机器变得像人一样思考,而是要确保机器的决策,能够体现人类社会最核心的价值观。

正如《论语》所言:「未知生,焉知死?」 我们在探索 AI 的无限可能时,更应首先明确人类社会生存发展的根本价值和底线,方能驾驭这股力量,共创一个有温度、有智慧的未来。