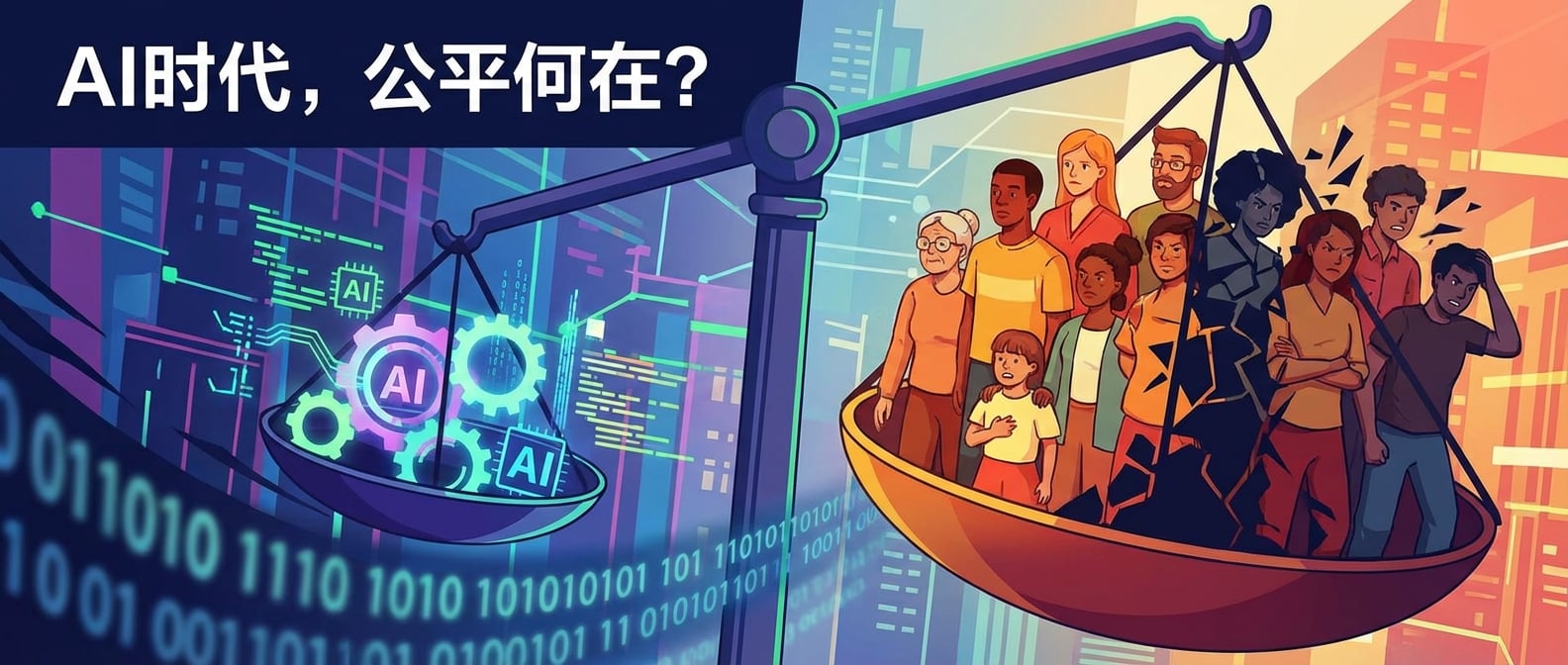

AI,真的是公正无私的「数字法官」吗?当招聘系统悄悄歧视女性,信贷算法默默拒绝特定人群,甚至医疗 AI 也带上了偏见……我们引以为傲的智能技术,是否正在制造新的「数字歧视」?算法偏见,这个看不见的「幽灵」,究竟如何渗透进我们的生活,又该如何被我们识破和制服?雪狼今天就和大家深入探讨算法偏见的成因、危害,以及在 AI 时代,我们如何筑起「防火墙」,避免让技术成为歧视的帮凶,构建一个真正公平、公正的智能社会。

一、算法偏见的「前世今生」:AI 的「镜子」#

算法偏见并非 AI 的「原罪」,而是人类社会偏见在数据和算法中的投射。AI 就像一面镜子,映照出了人类社会固有的不公平。

1. 数据偏见:偏见的「源头活水」#

-

历史数据的不公:AI 模型从历史数据中学习,如果历史数据本身就包含歧视(如历史上对女性或少数族裔的招聘偏见),AI 就会学习并复制这些偏见。

-

数据收集偏差:数据在收集过程中可能存在采样偏差,导致某些群体的数据不足或代表性不足。

-

标签偏见:数据标注人员可能无意识地将自身的偏见带入标注过程。

-

比喻:喂给 AI 的「脏面包」:

算法偏见就像你给 AI 喂了「脏面包」,它当然无法做出「干净」的判断。再强大的 AI,也无法超越它所学习的数据的质量。

2. 算法设计偏见:偏见的「传导器」#

-

特征选择偏见:开发者可能无意识地选择带有偏见的特征进行模型训练。

-

模型结构偏见:某些算法结构本身可能对特定数据敏感,放大偏见。

-

评估指标偏见:如果只关注整体准确率,而忽略了模型在不同子群体上的表现,就可能隐藏偏见。

3. 人类使用偏见:偏见的「放大器」#

-

当人类过度依赖 AI 的决策,而不对其结果进行批判性审查时,就可能放大 AI 的偏见。

-

AI 的决策被视为「客观」,从而使偏见更难被质疑。

二、算法偏见的「危害」:数字歧视的「魔爪」#

算法偏见远不止是技术问题,它可能带来严重的社会危害:

-

加剧社会不平等:导致信贷审批、求职、教育机会、医疗服务等方面的不公平待遇。

-

损害个人权益:影响个人声誉、财务状况、甚至自由。

-

降低社会信任:公众对 AI 系统和技术公平性的信任度降低。

-

固化刻板印象:AI 的偏见决策可能反过来强化社会中的刻板印象。

三、如何避免「数字歧视」:构建公平 AI 的「防火墙」#

避免算法偏见,需要技术、伦理、法律和社会治理的多维度协同努力,构建一套完整的「防火墙」机制。

1. 数据层面:源头治理,净化「食粮」#

-

多元化数据收集:确保训练数据的多样性、代表性,覆盖所有相关群体。

-

数据偏见检测与消除:利用技术手段识别并纠正数据中的偏见。

-

去识别化与隐私保护:在保护隐私的前提下,对数据进行处理。

-

比喻:给 AI 提供「均衡营养」:

就像人类需要均衡营养才能健康成长一样,AI 也需要「均衡营养」(无偏见、多样化的数据)才能做出公平的判断。

2. 算法层面:透明可控,公正「决策」#

-

公平性指标设计:在模型设计和评估中,不仅关注准确率,更要关注公平性指标(如不同群体的假阳性率、假阴性率)。

-

可解释性 AI (XAI):开发可解释的 AI 模型,让决策过程更加透明,便于审计和发现偏见。

-

偏见缓解技术:采用对抗性训练、后处理等技术手段,降低模型输出的偏见。

-

设计审查:在 AI 系统开发初期,引入伦理委员会或独立专家进行设计审查,评估潜在偏见风险。

3. 监管与社会层面:外部约束,共同「守护」#

-

法律法规:出台专门针对算法偏见的法律法规,明确企业和开发者的责任。

-

伦理委员会与审计:建立独立的算法伦理委员会,对高风险 AI 系统进行定期审计。

-

公众监督与教育:提升公众对算法偏见的认知,鼓励用户反馈,形成社会监督力量。

-

跨学科合作:鼓励技术、法律、社会学、伦理学等多领域专家共同参与算法偏见治理。

结语#

算法偏见是 AI 时代我们必须正视和解决的重大挑战。它警示我们,技术并非天然中立,其背后是人类的价值观和选择。避免「数字歧视」,不是要阻碍 AI 的发展,而是要确保 AI 技术能够更好地服务于全人类的福祉。

这需要我们从数据的源头开始,到算法的设计,再到 AI 的应用和监管,构建一套全生命周期的公平性保障机制。

正如《荀子·劝学》所言:「不积跬步,无以至千里;不积小流,无以成江海。」 避免算法偏见,构建公平的 AI 社会,需要我们每一个人从细微之处做起,持续不懈地努力。